Préambule:

L’arrivée de la GenAI fait les grands titres de la presse et des réseaux sociaux. Décriés ou encensés, ces nouveaux outils génèrent à la fois fantasmes et craintes, car ils impliquent un changement de comportement pour beaucoup, et ont des conséquences importante dans quasiment toutes les activités. Certaines d’entre elles sont encore aujourd’hui peu perçues, ou mal estimées. L’objectif de mes prochains articles est d’analyser les impacts de l’usage de la GenAI dans les domaines de la communication, la vie en société et la santé.

A l’origine de la création:

Sans rentrer dans une description technique des outils de GenAI, on peut dire que ces outils produisent des textes/images/vidéos à partir de « l’ingestion » d’une quantité très importante de textes/images/vidéo, qui sont agrégés et restitués afin de répondre à une demande d’un utilisateur (le prompt).

Plusieurs points sont à relever :

- Le résultat produit, est donc issu de données existantes, éventuellement propriété de leurs créateurs respectifs.

- La puissance extraordinaire des outils de GenAI permet d’une manière accessible à chacun, de concevoir et produire des documents texte / image / vidéo d’une grande qualité, qui ressemble à une production d’une personne spécialisée, ou tout au moins maitrisant des techniques de composition.

- La qualité des productions de la GenAI est telle que celles-ci peuvent être perçues comme des contenus originaux.

Ces trois point soulèvent autant de sujets de rupture qu’il convient d’analyser.

Qui est l’auteur?

Plusieurs exemples :

Ces trois cas mettent en avant d’une part le sujet de la protection des sources de données (le droit d’auteur) et l’éventuelle impossibilité de distinguer une information « native » produite par un humain, d’une information générée par une AI.

Reconnaitre si une production est ou non créée par une IA est complexe, il existe plusieurs outils (Copyleaks, Originality.AI, Writer, Crossplag…) qui tentent de détecter l’origine ChatGPT d’un document, mais il est possible de les tromper en réécrivant partiellement le texte Un solution proposée par Gregory Renard , un expert de l’IA installé dans la Silicon Valley depuis presque 10 ans, serait non pas de reconnaitre les signes de la GenAI, mais plutôt les attributs particulier du rédacteur humain qui est moins prévisible que la machine (perplexité), solution qui est utilisé en particulier dans GPTZero.

La GenAI peut être poussé encore plus loin afin de produire des contenus qui ressemblent à la vérité (basé sur des donnés réelles), mais qui sont volontairement déformés pour produire une vérité alternative, ou fake news :

La réalisation de Deepfake (changer le visage d’une personne sur une vidéo ou reproduire la voix d’une personne pour lui faire dire des choses qu’il n’aurait pas pu dire) est devenue à la portée de tout le monde.

Ce dernier point est particulièrement sensible dans cette année 2024 qui va voir voter pour élire ses dirigeants la moitié de la population mondiale (États-Unis, Taïwan, Inde, Union européenne, Russie). Près de 4,1 milliards de personnes vont voter, plus de 30 pays choisiront leur président, une vingtaine d’autres leurs parlementaires.

Ce sujet est particulièrement délicat, car la simplicité de générer des fakes news grâce à la GenAI permet à quiconque de produire un document voix, image ou vidéo potentiellement capable de perturber une élection majeure.

Inutile de dire que ce risque est démultiplié si ces outils sont utilisés par des professionnels dans un but politique ou de déstabilisation.

La production audiovisuelle est un autre secteur qui craint de se faire disrupter. Rien ne vous empêche avec des outils relativement simples de créer le nouvel épisode de votre série préféré. Ci-dessous un premier exemple avec le dessin animé « la famille Pierrafeu » générée via des prompts en texte:

La certification d’authenticité

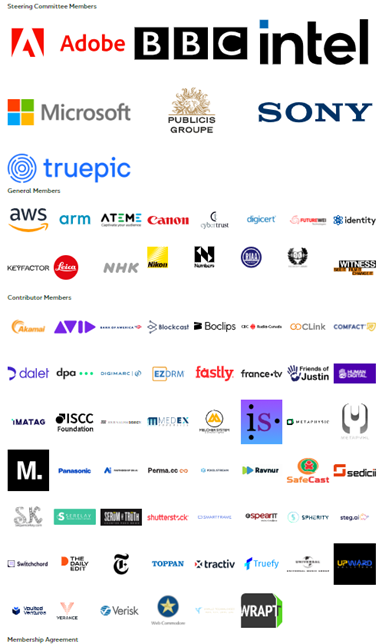

Certains médias commencent à éditer leur propre charte média, l’Europe édite des documents pour éviter la désinformation (https://www.touteleurope.eu/economie-et-social/l-action-de-l-union-europeenne-contre-la-desinformation-en-3-minutes/), et les journalistes sont sensibilisés au « fact checking » (https://www.reseau-canope.fr/fileadmin/user_upload/Projets/Valeurs_de_la_republique/EC_Le_journalisme_de_verification.pdf) mais ils n’ont pas à leur disposition d’outils simples leur permettant de valider l’authenticité d’un document). Une première réponse industrielle est en cours : #C2PA (https://c2pa.org/). Cette initiative regroupe un nombre important d’acteurs :

L’objectif de ce consortium est de retracer la provenance des médias. Pour résoudre ce problème à grande échelle pour les éditeurs, les créateurs et les consommateurs, #C2PA élabore des spécifications techniques pour établir la provenance et l’authenticité du contenu. L’idée est d’associer à chaque document dès sa création un « manifest » regroupant les infos relatives à celui-ci et de « sertir » l’ensemble en l’enregistrant dans une blockchain. Chaque modification du document ajoute un nouveau manifest qui est de nouveau serti à l’ensemble. Toute l’histoire du document est tracé depuis son origine.

Vidéo de présentation C2PA :

Les spécifications de C2PA s’appuient sur des scénarios, des flux de travail et des exigences rassemblés auprès d’experts du secteur et des organisations partenaires, notamment la Project Origin Alliance et la Content Authenticity Initiative (#CAI).

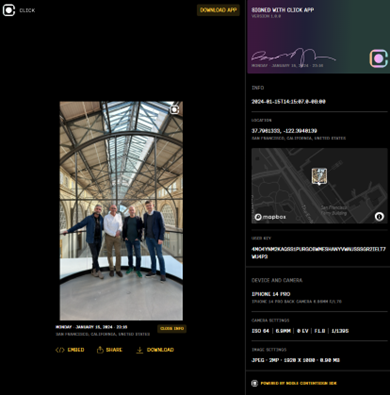

Certains outils intègrent déjà des solutions de certification, en particulier #Nodle, un acteur du Web3, qui a conçu l’application #click_app qui peut certifier directement depuis le smartphone une captation d’image.

Exemple d’une image certifiée par Click App de Nodle.io :

On y voit apparaitre les informations relatives à l’appareil de captation de l’image, la date et la localisation GPS, la signature et la clef de l’image. Pourraient même y être ajoutés les identifiants des autres utilisateurs potentiels à proximité ou tout autre information importantes pouvant garantir son authenticité.

Si cette image était modifiée, par exemple pour en modifier le cadrage ou la colorimétrie, l’outil de conception aurait ajouté un second manifest et une nouvelle signature :

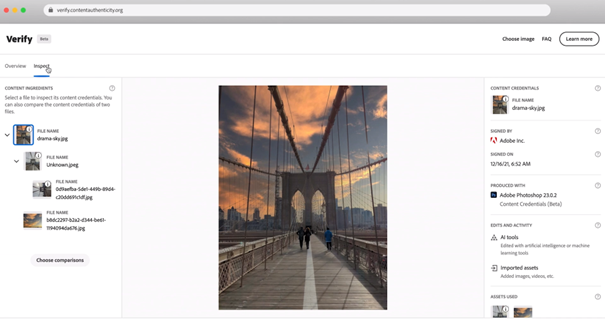

Le toolbox de C2PA permet d’authentifier des communiqués de presse (type pdf), des images et des vidéos. L’exemple ci-dessous présente un lecteur vidéo qui intègre le certificat d’authenticité ( « I » en haut à droite) de la vidéo diffusée :

Au diffuseur du contenu de vérifier que la chaine d’authentification est fournie avec l’image. Un document non authentifié ne doit pas être diffusé, et le certificat doit être présent dans le player du média ou le fil de discussion du réseau social.

Cette solution permet de régler les deux principales problématiques soulevées, l’origine de l’image authentique, et la nature de son traitement éventuel.

Remerciements :

Fabien Aufrechter pour les mises en relation et son expertise Web3

Gregory Renard pour sa vision globale et sa compétence dans le domaine de la GenAI

Andrew Jenks de Microsoft / C2PA

Simon Crownshaw de Microsoft

Micha Anthenor Benoliel de Nodle.io

Autres articles sur le sujet :